Одна из главных причин, по которой сайт может снижаться по позициям и трафику — нарастающее количество дубликатов страниц на сайте. Это страницы могут возникать из-за особенностей работы движка, неправильном желании получить увеличение трафика из поисковиков за счет шаблонного возрастания количества страниц на продвигаемом сайте, а также из-за сознательной или несознательной публикации ссылок третьими лицами на дубликаты с других ресурсов.

Актуальность дублей очень тесно пересекается с проблемой поиска основного типа адреса страницы поисковым анализатором. Часто робот определяет канонический адрес, если в динамическом URL изменен порядок параметров:

?&cat=11&product=24

Хотя, это та же страница, что и

?product=24&cat=11

Но чаще, при использовании ЧПУ, каноническую страницу тяжело идентифицировать, поэтому, полные и частичные дубликаты попадают в индекс.

Кстати говоря, для Яндекса дубли не так уж и страшны, и на страницы результатов поиска (которые являются частичными дубликатами друг друга) может приносить неплохой трафик, а вот Гугл к дублям относится более скептически (из-за борьбы с MFA и шаблонными сайтами).

Методика поиска дублей для сайта

Основные методы, с помощью которых достаточно быстро можно найти дубли страниц. Использовать периодически необходимо.

1. Гугл-вебмастер

В панели Гугл для вебмастеров найдите раздел «Оптимизация» – Оптимизация hmlt. Посмотрите количество повторов Описаний и Титлов.

Однако, таким способом можно найти лишь полные копии страниц, и не определить частичные дубли, у которых уникальные шаблонные заголовки.

2. Программа Xenu

Link Sleuth — одна из наиболее популярных программ у оптимизаторов, которая может помочь прововести технический аудит сайта Достаточно просто просканировать сайт, отсортировать результаты по заголовку и найти визуальные повторы заголовков и найти дублирующиеся заголовки. Тот же недостаток, что и у Гугла - нет частичных дублей.

3. Поисковая выдача

Результаты поиска могут отразить не только сам сайт, но и так называемое отношение поисковой машины к нему. Для поиска дублей в Гугле можно использовать специальный запрос.

site:mysyte.ru -site:mysyte.ru/&

Где составляющими являются:

site:mysyte.ru — показывает страницы сайта mysyte.ru, находящиеся в индексе Гугл.

site:mysyte.ru/& — показывает страницы сайта mysyte.ru, участвующие в поиске.

Вот так можно узнать малоинформативные страницы и частичные дубли, не участвующие в поиске и могут помешать страницам из основного индекса ранжироваться выше. Нужно на поиске обязательно кликнуть по ссылке "повторить поиск, упущенные результаты", если результатов было немного, чтобы узнать более полную картину.

Малоинформативные страницы в выдаче Гугла.

Теперь, когда все дубли страниц найдены, Вы можете их удалять, откорректировав cms сайта или добавив rel=canonical в заголовок страницы.

support@overpin.ru

+7 (4852) 90-56-65

Контактная информация

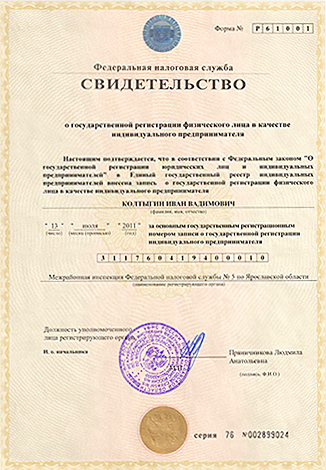

ИП Колтыгин Иван Вадимович

Юр.адрес: 150030, г. Ярославль, Московский проспект,

дом 74, офис 420;

Фактический адрес: 150030, г. Ярославль, Московский проспект, дом 74, офис 420;

ИНН: 760407102356;

ОГРН: 311760419400010;

ОКПО: 0177147792;

р/с: 40802810477020001171 в

ОАО «Сбербанк России» — Филиал Северный банк;

Кор.счет: 30101810500000000670 в

ГУ Банка России по Ярославской области;

БИК: 047888670;

ЯрославльМоскваМарс

г. Ярославль. Московский пр-кт. дом 74, офис 409

+7 (4852) 90-56-65

support@overpin.ru